iOS 5 取景器和實時濾鏡的制作

1.使用UIImagePickerController捕捉媒體制作取景器

UIImagePickerController是一個UINavigationController的子類,他是UIKit的一部分,因此不需要添加額外的框架,使用很簡單,但卻功能強大。我們可以使用它選擇來源媒體的類型,UIImagePicker有三種媒體來源可供選擇:UIImagePickerControllerSourceTypePhotoLibrary(系統的照片庫選擇照片),UIImagePickerControllerSourceTypeSavedPhotosAlbum(只能在保存的相冊中選擇照片),UIImagePickerControllerSourceTypeTypeCamera(使用攝像頭來獲取圖片或視頻)。因此我們既可以從本地獲取圖片,也可以調用攝像頭來捕捉新媒體,當我們選擇了捕捉的媒體時它就會調用它代理的didFinishPickingMediaWithInfo:方法。UIImagePickerControllerSourceType還允許開發者提供一個視圖,疊加在預覽視圖上面,因此我們可以通過自定義一個視圖來制作一個漂亮的取景器。

取景器制作步驟:1創建一個UIImagePickerController,使用攝像頭作為來源;2 必須在顯示圖像選取器之前,加上一個讓用戶拍照的方法;3簡歷一個Uiview作為疊加層,你可以像對待任何其他UIView一樣來處理這個疊加層,你可以加上動畫,加上任意的子視圖等等。下面的代碼演示了一個簡單的取景器。

-(void)showCustomCamera

{

//創建UIImagePickerController

picker=[[UIImagePickerController alloc]init];

picker.sourceType=UIImagePickerControllerSourceTypeCamera;//選取攝像頭作為來源

[picker setDelegate:self];

picker.cameraDevice=UIImagePickerControllerCameraDeviceFront;//強制選取前置攝像頭;

picker.showsCameraControls=NO;//禁用攝像頭空件

//創建疊加層

UIView *overLayView=[[UIView alloc]initWithFrame:self.view.bounds];

//取景器的背景圖片,該圖片中間挖掉了一塊變成透明,用來顯示攝像頭獲取的圖片;

UIImage *overLayImag=[UIImage imageNamed:@"overLay.png"];

UIImageView *bgImageView=[[UIImageView alloc]initWithImage:overLayImag];

[overLayView addSubview:bgImageView];

//在疊加視圖上自定義一個拍照按鈕

UIButton *takePhotoBtn=[UIButton buttonWithType:UIButtonTypeCustom];

[takePhotoBtn setFrame:CGRectMake(74, 370, 178, 37)];

[takePhotoBtn addTarget:self action:@selector(takePhoto:) forControlEvents:UIControlEventTouchUpInside];

[overLayView addSubview:takePhotoBtn];

//將視圖設置為攝像頭的疊加層

picker.cameraOverlayView=overLayView;

//顯示選取器

[self presentModalViewController:picker animated:YES];

}

-(void)takePhoto:(id)sender

{

[picker takePicture];//他將會自動調用代理方法完成照片的拍攝;

}

2.使用AV Foundation框架來實現實時濾鏡

UIImagePickerController處理的並不是原始攝像頭數據,他是在原始數據被處理成圖像後才開始訪問。而AV Foundation能在原始數據變成圖像之前就直接訪問它,這就使得我們能夠執行一些額外的暗箱操作,來實現實時濾鏡的制作。

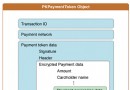

AVCaptureSession用來控制輸入設備(AVCaptureDeviceInput)視頻圖像到流入輸出緩沖區(AVCaptureOutput)的過程。一旦AVCaptureSession啟動以後,就會收集來自輸入設備的信息,並在適當的時候將這些信息輸出到數據緩沖區中。

AVCaptureVideoPreviewLayer默認情況下會顯示來自輸入設備的原始數據,如果要實現實時濾鏡或在這個圖層上繪制額外的物體,那麼就要沖視頻輸出緩沖區獲取數據幀數據,並對其進行處理,處理完畢後可將像素數據輸出到另一個圖層或者OpenGL上下文中。

AVCaptureConnection是一個類,用來在AVCaptureInput和AVCaptureOutput之間建立連接。AVCaptureSession必須從AVCaptureConnection中獲取實際數據。

相機實時效果制作過程:創建一個新的AVCaptureSession;設置對圖像質量的預置值;通過AVCaptureDevice來創建必要的輸入捕捉設備如攝像頭;通過AVCaptureStillImageOutput或者AVCaptureVideoDataOutput來添加一個輸出緩沖區;建立AVCaptureVideoPreviewLayer(預覽圖層),並將他添加到視圖控制器相關聯的視圖中,成為子視圖;啟動AVCaptureSession;獲取一個AVCaptureConnection的引用,該鏈接位於AVCaptureInput和AVCaptureVideoDataOutput之間;從AVCaptureVideoDataOutput中抓取單獨幀的數據,然後將其顯示在自己定制的預覽圖層中。

總結:

UIImagePickerController可以用於進行簡單的媒體捕捉,通過設置屬性sourceType和captureMode可以對UIImagePickerController進行簡單的配置,讓他以不同的分辨率捕捉靜止圖像或者視頻。

AVFoundation可以用來創建我們自己定制的捕捉解決方案,我們可以在幀數據剛剛從設備上捕捉到時就訪問這些數據,而不用等到圖像數據被最終確定之後,這就給我們提供相機實時效果以及其他的濾鏡操作。

- 上一頁:iOS虛擬鍵盤上添加動態按鈕

- 下一頁:ios菜鳥之路:圖片的拉伸的2種方法